Dataanmärkning eller datamärkning, som ni vet, är en evig process. Det finns ingen definierande ögonblick du kan berätta att du skulle sluta träna dina AI -moduler eftersom de har blivit helt korrekta och snabba med att leverera resultat.

Medan lanseringen av din AI-drivna modul bara är en milstolpe, sker AI-utbildning kontinuerligt efter lanseringen för att optimera resultat och effektivitet. På grund av detta plågas organisationer av oro över att generera massiva volymer relevant data för sina maskininlärningsmoduler.

Det är dock inte det bekymmer vi ska diskutera idag. Vi kommer att utforska de utmaningar som uppstår när denna oro generera data är fixad. Tänk dig att du har otaliga datagenererings -kontaktpunkter. Den mer problematiska frågan du kommer att möta vid denna tidpunkt är kommentera så stora datamängder.

Skalbar datamärkning är vad vi ska belysa idag eftersom de organisationer och team vi har pratat med alla har pekat oss på att dessa intressenter tycker att bygga maskintillit är mer utmanande än att generera data. Och som du vet kan maskinförtroendet endast byggas genom korrekt utbildade system som stöds av exakt kommenterade data. Så, låt oss ta en titt på 5 stora problem som minskar effektiviteten i datamärkningsprocesser.

5 utmaningar från den verkliga världen som utspädar insatser för datamärkning

Arbetsledning

Vi har upprepade gånger upprepat att datamärkning inte bara är tidskrävande utan också arbetskrävande. Dataannoteringsexperter spenderar oräkneliga timmar med att rengöra ostrukturerad data, sammanställa den och göra den maskinläsbar. Samtidigt måste de se till att deras kommentarer är exakta och av hög kvalitet.

Så organisationer är redo för utmaningen att balansera både kvalitet och kvantitet för att få ut resultat som gör skillnad och löser ett syfte. I sådana fall blir det extremt svårt och ansträngande att hantera arbetskraften. Medan outsourcing hjälper, företag som har dedikerade egna team för dataanmärkning möter hinder såsom:

- Medarbetarutbildning för datamärkning

- Arbetsfördelning mellan team och främjande av interoperabilitet

- Prestanda och framstegsspårning på både mikro- och makronivå

- Att ta itu med utmattning och omskola nya medarbetare

- Effektivisera samordningen mellan datavetenskapare, annotatorer och projektledare

- Eliminering av kulturella, språkliga och geografiska hinder och avlägsnande av fördomar från operativa ekosystem med mera

Spårning av ekonomi

Budgetering är en av de mest avgörande faserna i AI -utbildning. Den definierar hur mycket du är villig att spendera på att bygga en AI -modul när det gäller teknisk stack, resurser, personal och mer och hjälper dig sedan att beräkna exakt RoI. Nära 26% av företagen att satsa på att utveckla AI -system misslyckas halvvägs på grund av felaktig budgetering. Det finns varken transparens om var pengarna pumpas in eller effektiva mätvärden som ger realtidsinsikter till intressenter om vad deras pengar omsätts i.

Små och medelstora företag hamnar ofta i dilemmat om betalning per projekt eller per timme och i kryphålet med att anställa små och medelstora företag för anteckning syften vs rekrytering av en pool av mellanhänder. Allt detta kan elimineras under budgetprocessen.

Dataskyddsöverensstämmelse och efterlevnad

Medan antalet användningsfall för AI ökar, rusar företag för att ta sig fram och utveckla lösningar som höjer liv och erfarenhet. I andra änden av spektrumet ligger en utmaning som företag i alla storlekar måste uppmärksamma - dataskyddsfrågor.

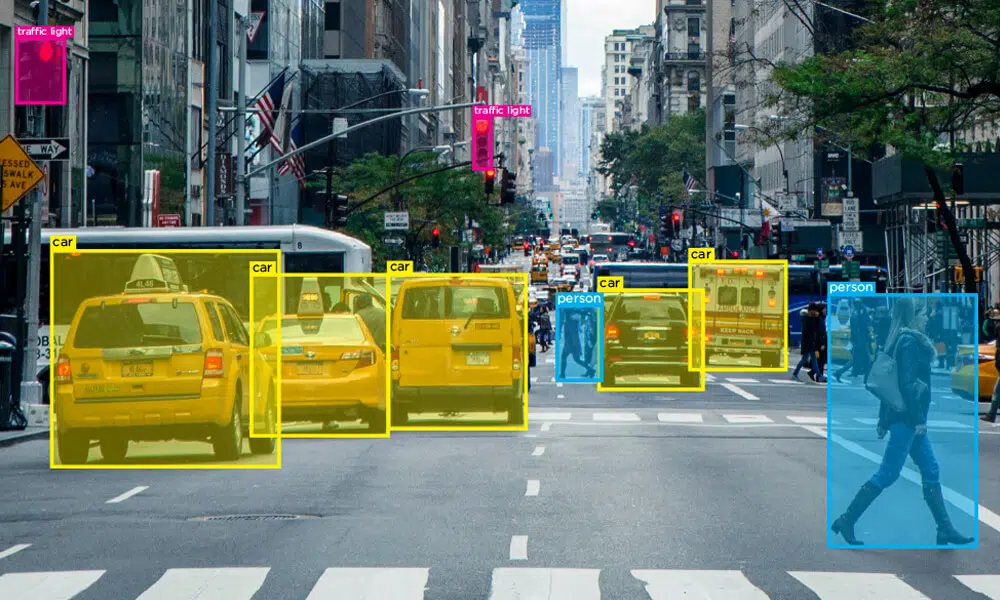

Du kanske känner till GDPR, CCPA, DPA och andra riktlinjer, men det finns nyare lagar och överensstämmelser som utvecklas och implementeras av nationer runt om i världen. När fler datamängder genereras blir sekretess avgörande i dataanmälan eftersom data från sensorer och datorsyn genererar data som har ansikten för människor, konfidentiella detaljer från KYC -dokument, registreringsnummer på fordon, licensnummer och mer.

Detta driver behovet av korrekt underhåll av sekretessstandarder och efterlevnad av rättvis användning av konfidentiell data. Tekniskt sett bör företag garantera en sund och säker miljö som förhindrar obehörig åtkomst till data, användning av obehöriga enheter i ett datasäkert ekosystem, olagliga nedladdningar av filer, överföring till molnsystem med mera. Lagar som reglerar dataskydd är komplicerade och man måste se till att varje enskilt krav uppfylls för att undvika juridiska konsekvenser.

Smarta verktyg och assisterade kommentarer

Av de två olika typerna av annoteringsmetoder - manuell och automatisk, är en hybridkommentarmodell idealisk för framtiden. Detta beror på att AI -system är bra på att bearbeta massiva datamängder sömlöst och människor är bra på att påpeka fel och optimera resultat.

AI-assisterade verktyg och annoteringstekniker är fasta lösningar på de utmaningar vi står inför idag eftersom det gör livet för alla intressenter som är involverade i processen enkelt. Smarta verktyg gör det möjligt för företag att automatisera arbetsuppgifter, pipelinehantering, kvalitetskontroll av kommenterade data och erbjuda mer bekvämlighet. Utan smarta verktyg skulle personalen fortfarande arbeta med föråldrade tekniker och driva mänskliga timmar betydligt för att slutföra arbetet.

Hantera konsekvens i datakvalitet och kvantitet

En av de viktiga aspekterna vid bedömning av datakvalitet är att bedöma definitionen av etiketter i datamängder. För de oinvigde, låt oss förstå att det finns två huvudtyper av datamängder -

- Objektiv data - data som är sann eller universell oavsett vem som tittar på den

- Och subjektiva data - data som kan ha flera uppfattningar baserat på vem som har åtkomst till den

Till exempel, märkning ett äpple som ett rött äpple är objektivt eftersom det är universellt men saker blir komplicerade när det finns nyanserade datamängder i handen. Tänk på ett kvickt svar från en kund på en recension. Annotatorn måste vara tillräckligt smart för att förstå om kommentaren är sarkastisk eller en komplimang för att märka den i enlighet därmed. Sentimentanalys moduler kommer att bearbetas baserat på vad annotatorn har märkt. Så, när flera ögon och sinnen är inblandade, hur når ett lag enighet?

Hur kan företag tillämpa riktlinjer och regler som eliminerar skillnader och ger en betydande mängd objektivitet i subjektiva datamängder?

Inslag Up

Det är ganska överväldigande, eller hur många utmaningar dataforskare och annotatörer står inför dagligen? De bekymmer vi diskuterat hittills är bara en del av utmaningen som härrör från konsekvensen tillgänglighet av data. Det finns mycket mer i detta spektrum.

Förhoppningsvis kommer vi dock att styra före allt detta tack vare utvecklingen av processer och system i datakommentarer. Det finns alltid outsourcing (shaip) tillgängliga alternativ, som erbjuder dig data av hög kvalitet baserat på dina krav.

Vi har upprepade gånger upprepat att datamärkning inte bara är tidskrävande utan också arbetskrävande. Dataannoteringsexperter spenderar oräkneliga timmar med att rengöra ostrukturerad data, sammanställa den och göra den maskinläsbar. Samtidigt måste de se till att deras kommentarer är exakta och av hög kvalitet.

Vi har upprepade gånger upprepat att datamärkning inte bara är tidskrävande utan också arbetskrävande. Dataannoteringsexperter spenderar oräkneliga timmar med att rengöra ostrukturerad data, sammanställa den och göra den maskinläsbar. Samtidigt måste de se till att deras kommentarer är exakta och av hög kvalitet. Du kanske känner till GDPR, CCPA, DPA och andra riktlinjer, men det finns nyare lagar och överensstämmelser som utvecklas och implementeras av nationer runt om i världen. När fler datamängder genereras blir sekretess avgörande i dataanmälan eftersom data från sensorer och datorsyn genererar data som har ansikten för människor, konfidentiella detaljer från KYC -dokument, registreringsnummer på fordon, licensnummer och mer.

Du kanske känner till GDPR, CCPA, DPA och andra riktlinjer, men det finns nyare lagar och överensstämmelser som utvecklas och implementeras av nationer runt om i världen. När fler datamängder genereras blir sekretess avgörande i dataanmälan eftersom data från sensorer och datorsyn genererar data som har ansikten för människor, konfidentiella detaljer från KYC -dokument, registreringsnummer på fordon, licensnummer och mer.