Om du utvecklar en AI-lösning är time-to-market för din produkt starkt beroende av att kvalitetsdatauppsättningar finns tillgängliga i tid för utbildningsändamål. Först när du har dina erforderliga datamängder i handen kan du initiera dina modellers träningsprocesser, optimera resultat och få din lösning förberedd för lansering.

Och du vet, att hämta kvalitetsdatauppsättningar i tid är en skrämmande utmaning för företag i alla storlekar och skalor. För de oinvigde, nära till 19% av företagen avslöjar att det är bristen på tillgänglighet av data som hindrar dem från att anta AI -lösningar.

Vi bör också förstå att även om du lyckas generera relevant och kontextuell data, dataanmärkning är en utmaning i sig. Det är tidskrävande och kräver utmärkt behärskning och uppmärksamhet på detaljer. Cirka 80% av AI: s utvecklingstid går på att kommentera datamängder.

Nu kan vi inte bara helt eliminera dataanmälningsprocesser från våra system eftersom de är grundpunkten för AI -utbildning. Dina modeller skulle misslyckas med att leverera resultat (än mindre kvalitetsresultat) om det inte finns någon kommenterad data i handen. Hittills har vi diskuterat en myriad av ämnen om databaserade utmaningar, annoteringstekniker och mer. Idag kommer vi att diskutera en annan avgörande aspekt som kretsar kring datamärkning i sig.

I det här inlägget kommer vi att utforska de två typerna av annotationsmetoder som används över hela spektrumet, vilka är:

- Manuell datamärkning

- Och automatisk datamärkning

Vi kommer att belysa skillnaderna mellan de två, varför manuellt ingripande är avgörande och vilka risker som är förknippade med automatisk datamärkning.

Manuell datamärkning

Som namnet antyder involverar manuell datamärkning människor. Dataannoteringsexperter tar hand om taggningselement i datamängder. Med experter menar vi små och medelstora företag och domänmyndigheter som vet exakt vad de ska kommentera. Den manuella processen börjar med att annotatorer förses med råa datamängder för annotering. Datauppsättningarna kan vara bilder, videofiler, ljudinspelningar eller transkript, texter eller en kombination av dessa.

Baserat på projekt, erforderliga resultat och specifikationer, arbetar annotatorer med att kommentera relevanta element. Experter vet vilken teknik som är mest lämplig för specifika datamängder och ändamål. De använder rätt teknik för sina projekt och levererar utbildningsbara datamängder i tid.

Även om manuell märkning bara är en del av processen, finns det en andra fas i annotationsarbetsflödet som kallas kvalitetskontroller och granskningar. I detta verifieras annoterade datamängder för äkthet och precision. För att göra detta antar företag en konsensusmetod, där flera kommentarer fungerar på samma datamängder för enhälliga resultat. Avvikelser löses även vid kommentarer och flaggning. Jämfört med annoteringsprocessen är kvalitetskontrollfasen mindre ansträngande och tidskrävande.

Automatisk datamärkning

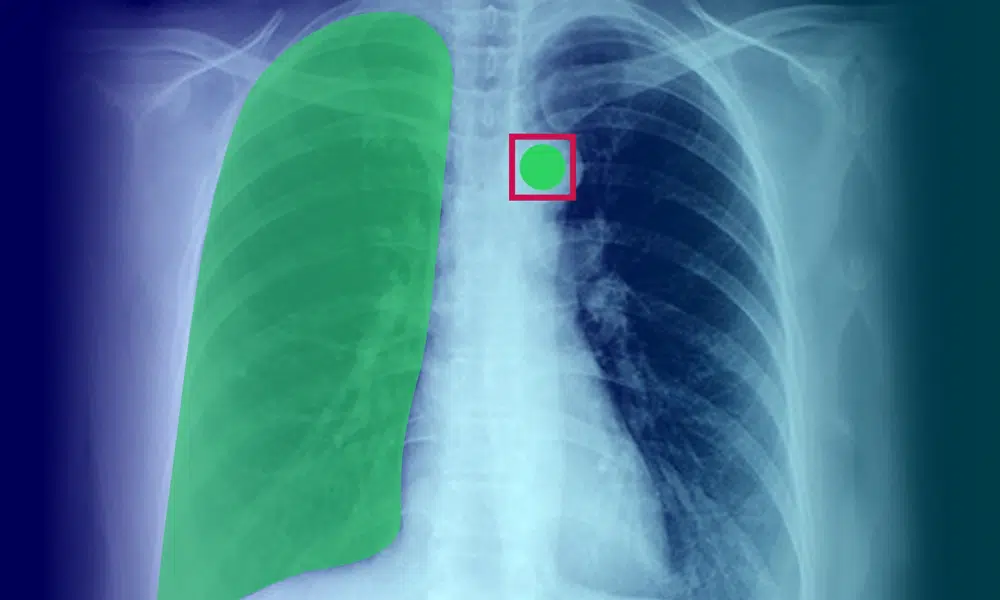

Så nu förstår du hur mycket manuell ansträngning som går åt till datamärkning. För att lösningar ska användas inom sektorer som vård, precision och uppmärksamhet på detaljer blir desto viktigare. För att bana väg för snabbare datamärkning och leverans av kommenterade data, blir automatiska datamärkningsmodeller gradvis framträdande.

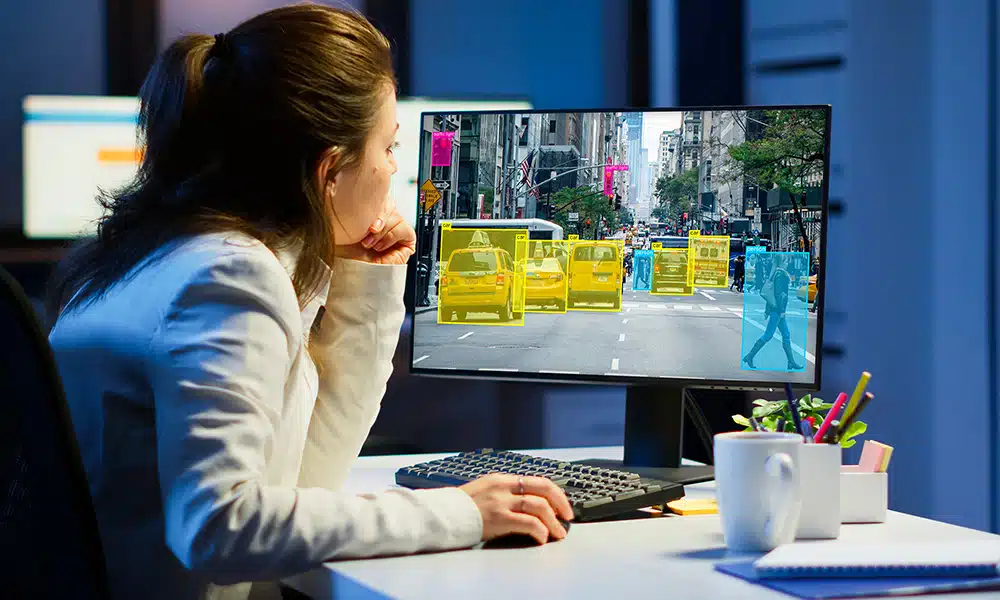

I denna metod tar AI -system hand om att kommentera data. Detta uppnås med hjälp av antingen heuristiska metoder eller maskininlärningsmodeller eller båda. I den heuristiska metoden skickas en enda datamängd genom en serie fördefinierade regler eller villkor för att validera en specifik etikett. Villkoren ställs av människor.

Även om detta är effektivt, misslyckas denna metod när datastrukturer ofta ändras. Att lägga upp villkor blir också komplicerat för att driva system för att fatta ett välgrundat beslut. Medan människor kan skilja mellan glass och limonad, vet vi inte hur hjärnan tar sig för att komma fram till skillnaden. Att replikera detta är mänskligt omöjligt i maskiner.

Detta ger upphov till ett antal problem med kvaliteten på resultaten från AI -system. Trots att automatiseringen startar behöver du en människa (eller ett gäng av dem) för att validera och fixa datatiketter. Och det här är en utmärkt segue till vårt nästa avsnitt.

AI-assisterad kommentar: Intelligens kräver hjärnor (hybridmetod)

För bästa resultat krävs en hybridmetod. Medan AI -system kan ta hand om snabbare märkning, kan människor validera resultat och optimera dem. Det kan vara en dålig idé att överlämna hela processen för dataanmärkning till maskiner.

Det finns en balans som är etablerad och processen kan också ske på kostnadseffektiva sätt. Experter kan komma med optimerade återkopplingsslingor för maskiner för att slå ut bättre etiketter, vilket i slutändan minskar behovet av inblandade manuella insatser. Med den betydande ökningen av maskinsäkerhetspoäng kan kvaliteten på märkta data också förbättras.

Inslag Up

Helt autonom datamärkning mekanismer skulle aldrig fungera - åtminstone för tillfället. Vad vi kräver är harmoni mellan människa och maskiner för att utföra en tråkig uppgift. Detta ökar också leveranstiden för kommenterade datamängder, där företag sömlöst kan initiera sina AI -utbildningsfaser. Och om du letar efter högkvalitativa datamängder för dina AI-modeller, kontakta oss idag.