En fungerande AI-modell är byggd på solida, pålitliga och dynamiska datauppsättningar. Utan rik och detaljerad AI-träningsdata till hands är det verkligen inte möjligt att bygga en värdefull och framgångsrik AI-lösning. Vi vet att projektets komplexitet dikterar och avgör vilken kvalitet som krävs på data. Men vi är inte exakt säkra på hur mycket träningsdata vi behöver för att bygga den anpassade modellen.

Det finns inget enkelt svar på vad som är rätt mängd träningsdata för maskininlärning behövs. Istället för att arbeta med en bollplank tror vi att en mängd metoder kan ge dig en korrekt uppfattning om vilken datastorlek du kan behöva. Men innan dess, låt oss förstå varför träningsdata är avgörande för framgången för ditt AI-projekt.

Betydelsen av träningsdata

På Wall Street Journals Future of Everything-festival sa Arvind Krishna, VD IBM, att nästan 80 % av arbetet i ett AI-projekt handlar om att samla in, rensa och förbereda data.' Och han var också av åsikten att företag ger upp sina AI-satsningar eftersom de inte kan hålla jämna steg med kostnaden, arbetet och tiden som krävs för att samla in värdefull utbildningsdata.

Fastställande av data provstorlek hjälper till att utforma lösningen. Det hjälper också att exakt uppskatta kostnaden, tiden och färdigheter som krävs för projektet.

Om felaktiga eller opålitliga datauppsättningar används för att träna ML-modeller kommer den resulterande applikationen inte att ge bra förutsägelser.

Hur mycket data räcker?

Det beror på.

Mängden data som krävs beror på flera faktorer, varav några är:

- Komplexiteten i Maskininlärningsprojekt du åtar dig

- Projektets komplexitet och budget bestäm också vilken träningsmetod du använder.

- Det specifika projektets behov av märkning och anteckningar.

- Dynamik och mångfald av datamängder som krävs för att träna ett AI-baserat projekt korrekt.

- Projektets datakvalitetsbehov.

Göra utbildade gissningar

Det finns inget magiskt tal för den minsta mängden data som krävs, men det finns några tumregler som du kan använda för att komma fram till ett rationellt tal.

Regeln om 10

Som en tumregel, för att utveckla en effektiv AI-modell bör antalet utbildningsdatauppsättningar som krävs vara tio gånger fler än varje modellparameter, även kallad frihetsgrader. '10' gånger-reglerna syftar till att begränsa variabiliteten och öka mångfalden av data. Som sådan kan den här tumregeln hjälpa dig att komma igång med ditt projekt genom att ge dig en grundläggande idé om den nödvändiga mängden datauppsättningar.

Deep Learning

Metoder för djupinlärning hjälper till att utveckla modeller av hög kvalitet om mer data tillförs systemet. Det är allmänt accepterat att 5000 märkta bilder per kategori borde räcka för att skapa en djupinlärningsalgoritm som kan fungera i paritet med människor. För att utveckla exceptionellt komplexa modeller krävs minst 10 miljoner märkta artiklar.

Datorsyn

Om du använder djupinlärning för bildklassificering är det enighet om att en datauppsättning med 1000 märkta bilder för varje klass är ett rimligt antal.

Inlärningskurvor

Inlärningskurvor används för att demonstrera maskininlärningsalgoritmens prestanda mot datamängden. Genom att ha modellfärdigheten på Y-axeln och träningsdataset på X-axeln är det möjligt att förstå hur storleken på datan påverkar resultatet av projektet.

Nackdelarna med att ha för lite data

Du kanske tycker att det är ganska uppenbart att ett projekt behöver stora mängder data, men ibland misslyckas även stora företag med tillgång till strukturerad data att skaffa den. Träning på begränsade eller smala datamängder kan stoppa maskininlärningsmodeller från att uppnå sin fulla potential och öka risken för att ge felaktiga förutsägelser.

Även om det inte finns någon gyllene regel och grov generalisering vanligtvis görs för att förutse behov av träningsdata, är det alltid bättre att ha stora datamängder än att lida av begränsningar. Databegränsningen som din modell lider av skulle vara begränsningarna för ditt projekt.

Vad du ska göra om du behöver fler datamängder

Även om alla vill ha tillgång till stora datamängder är det lättare sagt än gjort. Att få tillgång till stora mängder datauppsättningar av kvalitet och mångfald är avgörande för projektets framgång. Här ger vi dig strategiska steg för att göra datainsamlingen mycket enklare.

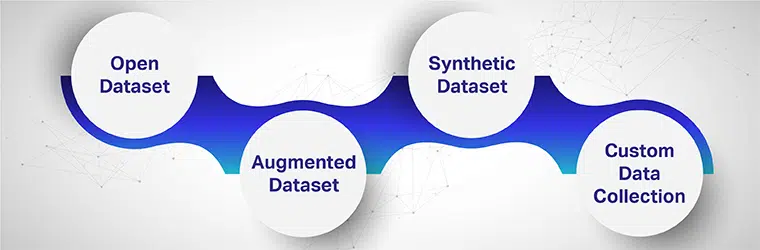

Öppna Dataset

Öppna datauppsättningar anses vanligtvis vara en "bra källa" för gratis data. Även om detta kan vara sant, är öppna datauppsättningar inte vad projektet behöver i de flesta fall. Det finns många platser som data kan hämtas från, till exempel statliga källor, EU Open dataportaler, Google Public data explorers och mer. Det finns dock många nackdelar med att använda öppna datauppsättningar för komplexa projekt.

När du använder sådana datamängder riskerar du utbildning och testning din modell på felaktiga eller saknade data. Datainsamlingsmetoderna är i allmänhet inte kända, vilket kan påverka projektets resultat. Sekretess, samtycke och identitetsstöld är betydande nackdelar med att använda öppna datakällor.

Förstärkt datauppsättning

När du har några mängd träningsdata men inte tillräckligt för att uppfylla alla dina projektkrav, du måste tillämpa dataförstärkningstekniker. Den tillgängliga datauppsättningen används på nytt för att möta modellens behov.

Dataproverna kommer att genomgå olika transformationer som gör datamängden rik, varierad och dynamisk. Ett enkelt exempel på dataförstärkning kan ses när man hanterar bilder. En bild kan utökas på många sätt – den kan klippas ut, ändra storlek, spegelvändas, förvandlas till olika vinklar och färginställningar kan ändras.

Syntetiska data

När det inte finns tillräckligt med data kan vi vända oss till syntetiska datageneratorer. Syntetisk data kommer väl till pass när det gäller överföringsinlärning, eftersom modellen först kan tränas på syntetisk data och senare på den verkliga datamängden. Till exempel kan ett AI-baserat självkörande fordon först tränas i att känna igen och analysera föremål i dator vision videospel.

Syntetisk data är fördelaktig när det saknas verklighet data att träna och testa din utbildade modeller. Dessutom används det också när det handlar om integritet och datakänslighet.

Anpassad datainsamling

Anpassad datainsamling är kanske idealisk för att generera datauppsättningar när andra formulär inte ger de önskade resultaten. Datauppsättningar av hög kvalitet kan genereras med hjälp av webbskrapningsverktyg, sensorer, kameror och andra verktyg. När du behöver skräddarsydda datauppsättningar som förbättrar prestandan hos dina modeller kan det vara rätt drag att skaffa anpassade datauppsättningar. Flera tredjepartstjänsteleverantörer erbjuder sin expertis.

För att utveckla högpresterande AI-lösningar måste modellerna tränas på tillförlitliga datauppsättningar av god kvalitet. Det är dock inte lätt att få tag på rika och detaljerade datauppsättningar som positivt påverkar resultaten. Men när du samarbetar med pålitliga dataleverantörer kan du bygga en kraftfull AI-modell med en stark databas.

Har du ett bra projekt i åtanke men väntar på skräddarsydda datauppsättningar för att träna dina modeller eller kämpar för att få rätt resultat av ditt projekt? Vi erbjuder omfattande utbildningsuppsättningar för en mängd olika projektbehov. Utnyttja potentialen i Shaip genom att prata med någon av våra datavetare idag och förstå hur vi har levererat högpresterande, kvalitetsdatauppsättningar för kunder tidigare.